Diferencias entre robots.txt y noindex

Si estás leyendo este artículo es probable que ya estés familiarizado con el concepto de desindexación y por qué estás considerando implementarlo en algunas de tus páginas. El propósito de este artículo es aclarar las principales diferencias entre dos métodos comunes para lograr la desindexación: el archivo robots.txt y la etiqueta “noindex”. Vamos a explorar cada uno, entender sus implicaciones y despejar cualquier confusión que pueda surgir.

Desindexar que significa

La desindexación implica que determinadas páginas, seleccionadas de manera estratégica para favorecer el posicionamiento SEO, no sean rastreadas ni indexadas por los motores de búsqueda de Google.

Sin embargo, puede surgir la pregunta sobre qué método es más adecuado para lograrlo ya que ambos existen, pero sus aplicaciones y resultados pueden variar.

¿Qué es el Robots.txt?

El archivo robots.txt es un componente esencial en la estrategia SEO (Search Engine Optimization) y la administración de la visibilidad en línea de tu página web. Es un archivo de texto simple que se aloja en la raíz de un dominio y tiene como objetivo principal comunicar a los motores de búsqueda sobre cómo deben interactuar con el contenido de la web.

De forma sencilla el robots.txt actúa como un protocolo de comunicación entre el propietario de la web y los rastreadores de los motores de búsqueda, también conocidos como bots. Este archivo proporciona instrucciones sobre qué partes específicas del sitio web deben ser rastreadas y cuáles deben ser ignoradas por los motores de búsqueda.

El archivo robots.txt se compone principalmente de directivas como “User-agent” y “Disallow”.

La directiva “User-agent” especifica a qué rastreadores se aplican las siguientes instrucciones, y “Disallow” indica qué áreas del sitio no deben ser rastreadas.

Al agregar una línea “Disallow: /private/” al archivo, se le indica a los motores de búsqueda que eviten rastrear cualquier contenido dentro del directorio “private”.

Aunque el robots.txt no se creó específicamente para desindexar, su consecuencia natural es la no indexación de las páginas bloqueadas.

¿Cómo utilizar el Robots.txt?

La edición del archivo robots.txt puede realizarse de varias maneras, dependiendo de tu plataforma. Para usuarios de WordPress, herramientas o plugins como SEO by Yoast o Rank Math facilitan la edición de este tipo de acciones.

También es posible acceder al archivo mediante FTP o Cpanel, editándolo directamente en el código de la página web.

¿Qué es la Etiqueta ‘noindex’?

Las metaetiquetas ‘noindex’ se entiendes como los fragmentos de código HTML que se incluyen en las páginas web.

Estas etiquetas informan a los motores de búsqueda sobre cómo deben tratar la página en términos de rastreo e indexación. Es importante destacar que todas las páginas necesitan contener esta etiqueta; si no está presente, se asumirá que la página es indexable y sigue a otras páginas.

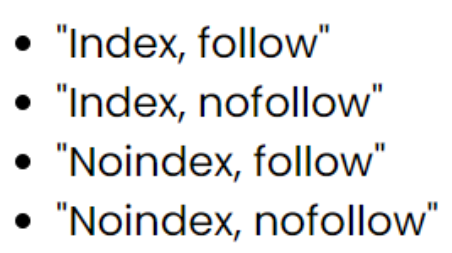

Dentro de la etiqueta ‘noindex’, hay cuatro combinaciones posibles:

Cada combinación establece si la página debe indexarse y si los enlaces en ella deben seguirse.

¿Cómo utilizar una etiqueta ‘noindex’?

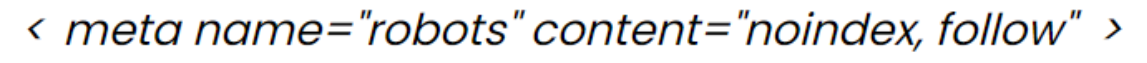

Independientemente del CMS o la estructura de tu web, la etiqueta ‘noindex’ se implementa mediante el código HTML:

Esta etiqueta debe ubicarse en la cabecera de cada página en la que desees aplicar estas indicaciones.

Diferencias entre Robots.txt vs. ‘noindex’

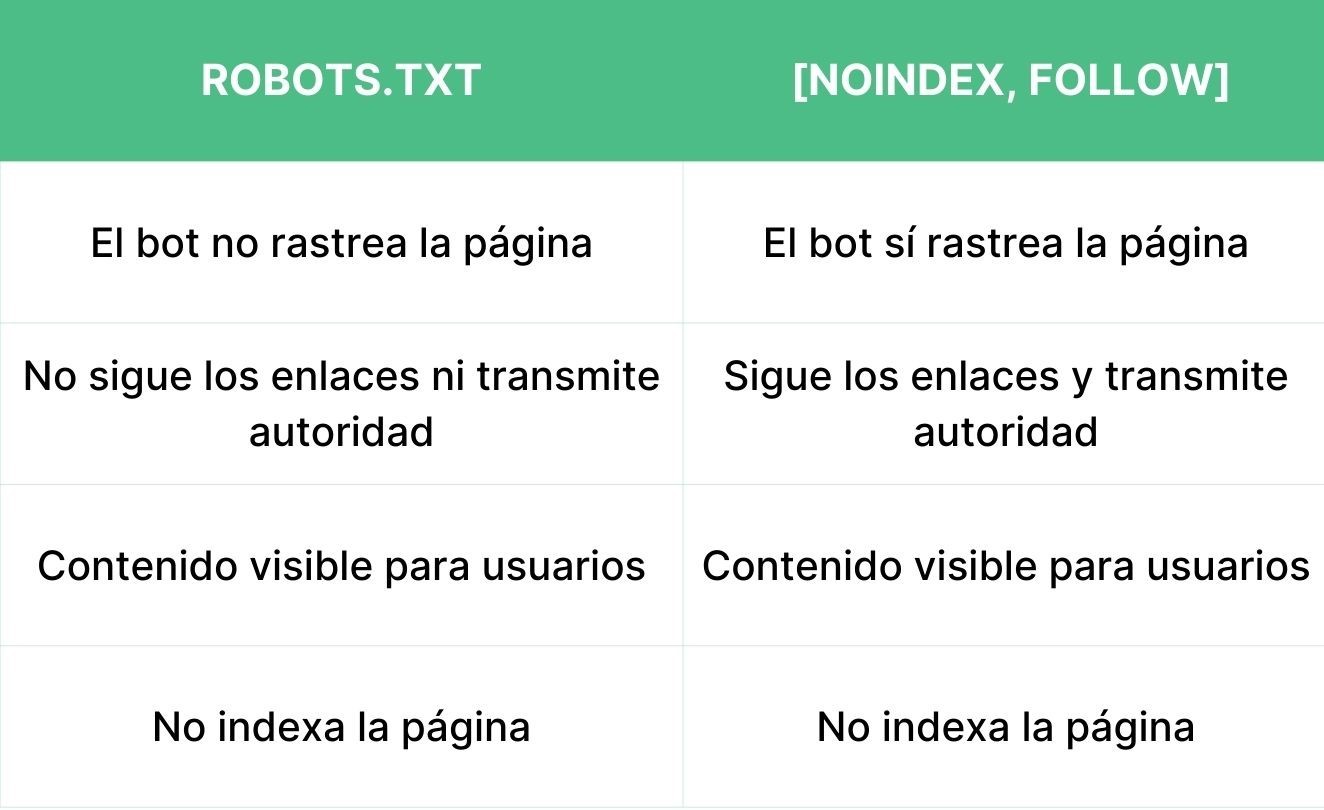

Aunque ambos métodos comparten el objetivo final de desindexar, presentan diferencias esenciales, especialmente en el aspecto del rastreo:

La principal distinción radica en el rastreo: mientras que el robots.txt impide el rastreo, la etiqueta ‘noindex’ permite que el bot acceda y rastree el contenido, aunque sin indexarlo.

Cuál elegir Robots.txt vs. ‘noindex’

Es crucial comprender estas diferencias para elegir el método más adecuado según tus necesidades. Aunque el meta robots ofrece flexibilidad al permitir el rastreo de enlaces internos, puede implicar un uso ineficiente de los recursos de rastreo.

Un escenario a tener en cuenta es cuando se utiliza “noindex” en la etiqueta meta y, al mismo tiempo, se bloquea con “Disallow” en el robots.txt. En algunas situaciones, esto puede llevar a que Google no desindexe completamente las páginas bloqueadas.

Esperamos que esta guía te ayude a tomar decisiones informadas sobre cómo desindexar correctamente tus páginas, optimizando así la visibilidad de tu sitio web en los motores de búsqueda. Recuerda siempre monitorear cualquier inconsistencia a través de las herramientas como Search Console para garantizar una desindexación efectiva.

Si necesitas ayuda para llevar el SEO de tu empresa, en Difuso contamos con un equipo de profesionales en gestión de marketing digital valencia, que te ayudarán a sacarle el mejor rendimiento a tu web y a optimizar tu posicionamiento.